До Всесвітнього дня обізнаності про доступність Google представив низку інновацій, які розширюють можливості людей з інвалідністю у користуванні цифровими технологіями. Нові функції на Android та Chrome допомагають людям з порушеннями зору та слуху завдяки потужному потенціалу штучного інтелекту.

TalkBack із новими можливостями: бачити більше крізь слова

Екранний читач TalkBack на Android отримав потужне оновлення. Тепер він може описувати зображення значно докладніше завдяки вбудованому штучному інтелекту. Навіть якщо картинка не має підпису, користувач може почути опис типу: "На фото — нічне місто з оперним театром і мостом, підсвіченим вогнями". І що важливо — ця функція працює навіть без підключення до Інтернету.

Емоційні субтитри: новий рівень розуміння

Для людей з порушеннями слуху впроваджено функцію Expressive Captions, яка генерує субтитри з урахуванням емоцій і звуків — сміху, аплодисментів, інтонацій. Тепер перегляд відео стає значно ближчим до повноцінного досвіду, навіть без звуку. Субтитри доступні в реальному часі на пристроях із новою версією Android.

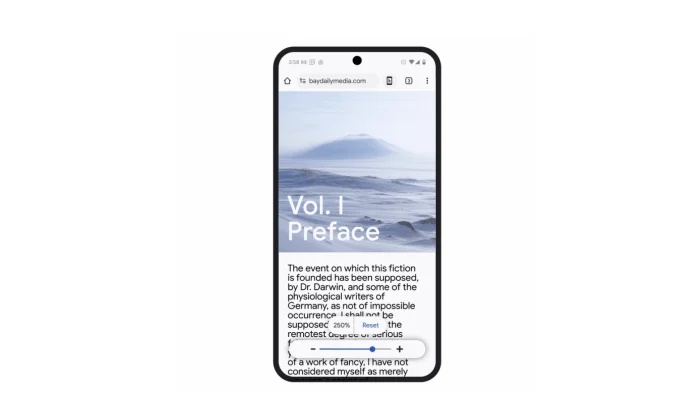

Chrome також стає зручнішим

У браузері Chrome на Android тепер можна масштабувати текст без спотворення верстки — важлива деталь для людей зі слабким зором. Крім того, десктопна версія отримала функцію розпізнавання тексту у сканованих PDF-файлах, що дає змогу екранним читачам озвучувати такі документи.

Більше мов — більше доступу

Розвиток мовної інклюзивності також у центрі уваги. Зроблено кроки до розпізнавання мов, які раніше ігнорувалися. Нові інструменти створені для підтримки мовних спільнот, що були недостатньо представлені у цифровому світі.